Роботы и закон: будут ли машины сидеть в тюрьме?

Автономные машины скоро будут брать на себя все больше работы и принимать решения. Но кто же будет нести ответственность, если искусственный интеллект причинит ущерб? Вопрос остается открытым.

Когда после полудня 7 июля 2015 года техник Ванда Х. зашла в секцию 140 сборочной линии автозавода в американском штате Мичиган, она стала делать то, что делала всегда, — проводить стандартные работы по техническому обслуживанию сварочного робота. Но внезапно соседний робот оказался в ее рабочей зоне, чтобы смонтировать сцепное приспособление. Все произошло настолько неожиданно, что Ванда не смогла вовремя среагировать: робот настолько тяжело ранил женщину в голову, что прибывшие санитары смогли только констатировать смерть.

До сих пор неясно, что именно привело к этому несчастному случаю. Смежные секции были отделены от места трагедии надежными дверями, машины остановлены, а в том креплении, на которое нацелился робот, уже были установлены муфты. Иными словами, есть масса причин, по которым робот не должен был делать то, что он сделал. И тем не менее это произошло. Кроме того, непонятно, кто должен отвечать за гибель техника. Чтобы это выяснить, овдовевший супруг погибшей подает иски ко всем пяти компаниям, которые имеют хотя бы какое-то отношение к роботу: от производителя до обслуживающей фирмы.

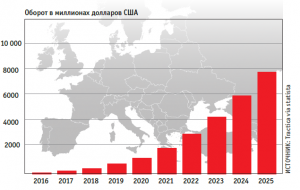

Число роботов будет расти

Аналитики ожидают, что использование искусственного интеллекта на европейских предприятиях в ближайшие годы сильно вырастет. В 2025 году системы ИИ будут зарабатывать уже $7,8 млрд.

Хотя случаи, когда люди получают травмы или даже гибнут по вине роботов, пока еще достаточно редки, в будущем их число возрастет — хотя бы потому, что в будущем будет массированно увеличиваться присутствие роботов в рабочей и повседневной сфере.

Это в первую очередь касается дорожного движения: кто окажется виноватым, если алгоритм автономного автомобиля неверно оценит маневр при обгоне, не заметит велосипедиста или повредит другой автомобиль при парковке? Пользователь авто? Производитель? Или и вовсе программист? Хотя при продвижении автономных транспортных средств автопроизводители в первую очередь делают акцент на безопасности, и под управлением компьютера происходят аварии, что показал случай в швейцарском городке Сьон. Там в сентябре 2016 года автономный почтовый автобус не заметил открытой задней двери грузовика и зацепил ее, проезжая мимо.

Человек, выполнявший функцию второго водителя на стадии тестирования автобуса, мог применить экстренное торможение, но он тоже неправильно оценил ситуацию. И как раз из-за этого второго пилота из плоти и крови с точки зрения ответственности за ущерб не было различия с «нормальным» почтовым автомобилем, о чем сообщила в ответ на запрос эксплуатирующая организация Postauto Schweiz AG. Ущерб, причиненный грузовику, был возмещен по страхованию гражданской ответственности. Тем не менее компания Postauto Schweiz AG заявила, что «ситуацию нужно будет оценить заново, если законом будут разрешены автономные автобусы без сопровождающего лица».

Правительства рассматривают вопрос ответственности роботов

Умный автобус с автономным управлением почтовой службы Швейцарии, эксплуатируемый в тестовом режиме, причинил ущерб, который был оплачен по страхованию гражданской ответственности

В целях урегулирования пока остающихся неясными вопросов ответственности в отношении автономных автомобилей уже появляются законодательные инициативы: например, в Великобритании в начале февраля правительство представило законопроект, открывающий путь для новых видов страхования по принципу «два в одном». Таким образом предполагается, что страховка будет распространяться не только на управление водителем, но и на беспилотный, автономный режим. Данный закон принуждает страховые компании к возмещению ущерба, причиненного автономными транспортными средствами.

В Германии тоже есть очень похожие планы: тамошнее Министерство транспорта разработало законопроект, согласно которому в будущем водителям при определенных условиях будет разрешено передавать управление компьютеру. Однако в основном принципе так называемой ответственности за ущерб это ничего не меняет: если водитель может заверить, что он не виноват, отвечает тот, кто эксплуатирует транспортное средство, то есть его владелец. Вероятный ущерб должен возмещаться по его страховке, даже если виновником аварии является искусственный интеллект.

Тем не менее, по мнению Йоахима Мюллера, председателя правления страховой компании Allianz Versicherungs-AG, реформа системы страхования и ответственности как в Великобритании в Германии не требуется. На запрос CHIP он пояснил: «В Великобритании пострадавшая сторона всегда должна доказывать вину при аварии, ответственность владельца за ущерб там не применяется». Мюллер считает, что ответственность за ущерб — это идеальная правовая база для поэтапной автоматизации транспортных средств: «Она гарантирует, что пострадавшая сторона ДТП получит возмещение вне зависимости от того, что стало причиной аварии: ошибка водителя или системы». При ошибке системы или заводском браке страховая компания может предъявить требования о возмещении убытков к производителю.

Проблема самообучающихся алгоритмов

реформировать страхование»

Иоахим Мюллер,

председатель правления страховой компании Allianz Versicherungs-AG

Однако, возможно, в скором времени все будет не так просто. На данный момент в спорных случаях ответственность несут производитель и программист — за ошибки в выпущенном программном обеспечении. Но существуют еще и самообучающиеся алгоритмы, которые, как ясно уже из названия, разрабатывают себя сами. Если, к примеру, программное обеспечение однократно запрограммировано на автоматическое распознавание образов, его дальнейшая разработка производится не через изменение кода, а через обучение с использованием огромных массивов данных.

По окончании процесса обучения самообучающееся программное обеспечение оказывается в состоянии принимать решения, которые уже выходят за пределы изначального замысла программиста или производителя. Особенно это заметно в случае с алгоритмом AlphaGo, разработанным подразделением Google DeepMind, занимающегося вопросами глубокого обучения (Deep Learning).

После однократного обучения программному обеспечению удалось победить лучшего в мире игрока в азиатской стратегической игре го. Интересно то, что при почти бесчисленном количестве возможных ходов невозможно просчитать партию с помощью имеющихся на сегодняшний день средств. Поэтому при победе и поражении решающим фактором по большей части оказывается интуиция игрока. Однако еще удивительнее то, как машина победила человека: команда DeepMind потом выяснила, что решающий ход противоречил не только всем традиционным правилам игры го, история которой насчитывает несколько тысячелетий, но и человеческой интуиции. То есть это был ход, который не сделал бы человек.

Решающий шаг уже сделан

Пока такие алгоритмы, как AlphaGo, потребляют колоссальные вычислительные мощности и отличаются необычайно высоким энергопотреблением по сравнению с человеческим мозгом. Но решающий шаг, а именно обретение способности развиваться, выходя за пределы человеческих возможностей, уже сделан. Проблема в следующем: если в результате решения, принятого таким алгоритмом, как AlphaGo, будет причинен ущерб, смогут ли как программисты, так и производители с полным на то основанием возразить, что они не имеют никакого отношения к данному решению?

Поэтому в недавно выпущенных рекомендациях для Еврокомиссии Европарламент требует введения общеевропейских правил в отношении ответственности — так называемых «законов для роботов». Помимо четких правил в отношении ответственности для автономных транспортных средств депутаты хотят добиться от комиссии введения в долгосрочной перспективе специального правового статуса для искусственного интеллекта — к примеру, в форме «электронного лица».

Концепция электронной личности должна будет применяться для всех случаев, в которых роботы «принимают самостоятельные решения» — такая формулировка приведена в решении. Кроме этого, парламентарии предлагают введение добровольного этического кодекса поведения для ученых и дизайнеров в сфере робототехники. Так должно гарантироваться, что дизайн и использование роботов будут уважать человеческое достоинство и соответствовать правовым и этическим стандартам.

Программному обеспечению требуются моральные ограничения

Профессор, доктор Армин Грунвальд, Институт философии при Институте технологий в Карлсруэ (KIT)

Очень похоже звучат и размышления профессора Армина Грунвальда, который преподает философию техники в немецком Технологическом институте Карлсруэ (KIT): «В первую очередь самообучающееся программное обеспечение следует регулярно проверять на предмет того, соответствует ли оно еще нашим правовым и этическим нормам», — сказал он в беседе с CHIP. В процессе обучения не стоит полагаться на то, что в итоге все пойдет хорошо. Хорошим примером неудачного машинного обучения стал эксперимент Microsoft с автономным ботом для Twitter по имени Тай, который в течение очень короткого времени превратился в расиста и сексиста, и Microsoft пришлось экстренно выдергивать штекер.

Грунвальд пришел к выводу, что «обучение не может быть хорошим само по себе». Поэтому, по мнению Грунвальда, следует заранее определять, чему вообще стоит обучаться. Он призывает программистов к тому, чтобы при разработке программного обеспечения они ориентировались на существующую систему ценностей, даже если запрограммировать это будет не очень-то просто.

От «электронного лица» в том виде, как его рассматривает Европарламент, Грунвальд много не ждет. Даже если таким образом объявить искусственный интеллект ответственным за свои действия, по его мнению, здесь изначально имеется существенное слабое место: отсутствие возможности применения санкций. «Нет смысла приговаривать программу к денежному штрафу или тюремному сроку», — считает Грунвальд. Тем более что, к примеру, такой вид искусственного интеллекта, как финансовый алгоритм, не имеет никакого физического воплощения.

В случае с гибелью техника Ванды Х. вышедшего из-под контроля робота не отправили в тюрьму. То, что он, по-видимому, активировался самостоятельно, было трагической случайностью. Но в скором времени самостоятельно действующие машины будут не случайностью, а обычным явлением. И пока у человечества еще есть немного времени, чтобы к этому подготовиться.

ФОТО: ShutterStock/Fotodom.ru; European Union 2017/Source: EP (o.); KIT (u.)

Читайте нас в социальных сетях

Читайте нас в социальных сетях